WASHINGTON – Numa realidade paralela, a Rainha Isabel come bolinhos de queijo, Saddam Hussein armado em punho entra num ringue de luta livre e o Papa João Paulo II experimenta o skate.

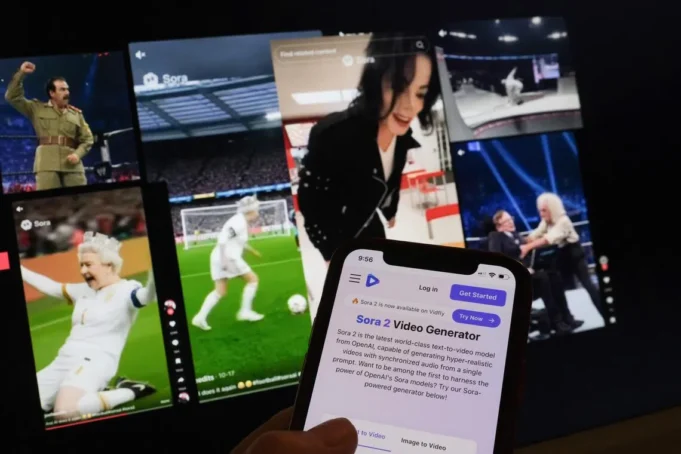

Vídeos de IA hiper-realistas de celebridades falecidas – criados com aplicativos como

Sora fácil de usar do OpenAI

– tornou-se viral online, gerando debate sobre a gestão de retratos de mortos.

Lançado em setembro, o aplicativo OpenAI, amplamente conhecido como máquina deepfake, divulgou uma coleção de vídeos de figuras históricas, incluindo Winston Churchill e celebridades como Michael Jackson e Elvis Presley.

Em um vídeo do TikTok analisado pela AFP, a Rainha Elizabeth, usando pérolas e uma coroa, chega a uma luta livre em uma scooter, escala uma cerca e pula em um lutador.

Outro vídeo do Facebook mostra a falecida rainha elogiando um bolinho de queijo “laranja deslumbrante” no corredor de um supermercado, enquanto outro a mostra jogando futebol.

Mas nem todos os vídeos que usam o modelo Sora 2 da OpenAI provocaram risadas.

Em outubro, a OpenAI impediu que usuários criassem vídeos do ícone dos direitos civis Martin Luther King Jr.

Apresentei uma reclamação sobre a representação rude.

.

Alguns usuários criaram vídeos retratando Martin Luther King Jr. fazendo barulhos de macaco durante seu famoso discurso “Eu tenho um sonho”, ilustrando como os usuários podem interpretar livremente figuras públicas e fazê-las dizer ou fazer coisas que nunca fizeram.

“Estamos a entrar num vale misterioso”, disse Constance de Saint Laurent, professora da Universidade Maynooth, na Irlanda, referindo-se a um fenómeno em que as interações com artefactos são demasiado humanas e causam ansiedade.

“É traumático se de repente você começar a receber vídeos de familiares falecidos”, disse ela à AFP. “Estes (vídeos) têm consequências reais.”

Nas últimas semanas, os filhos do falecido ator Robin Williams, do comediante George Carlin e do ativista Malcolm X acusaram Sora de usá-lo para criar vídeos compostos de seus pais.

Zelda Williams, filha de Robin Williams, recentemente chamou o conteúdo de “perturbador” e pediu-lhe que “parasse de enviar vídeos de IA do pai dela” no Instagram.

Um porta-voz da OpenAI disse à AFP que embora “há um forte interesse pela liberdade de expressão na representação de figuras históricas”, as figuras públicas e as suas famílias devem ter o controlo final sobre as suas imagens.

Acrescentou que para as pessoas que “morreram recentemente”, um representante autorizado ou proprietário de propriedade pode solicitar que a sua imagem não seja usada na Sola.

“A OpenAI diz que quer que as pessoas controlem sua aparência, mas lançou uma ferramenta que claramente faz o oposto”, disse à AFP o cofundador da GetReal Security, Hany Farid, professor da Universidade da Califórnia, Berkeley.

“Eles (principalmente) pararam de fazer vídeos do MLK Jr, mas isso não impediu os usuários de utilizarem as identidades de muitas outras celebridades.”

“Mesmo que a OpenAI implemente algumas salvaguardas para proteger MLK Jr, haverá outros modelos de IA que não o farão. Portanto, este problema definitivamente vai piorar”, disse o professor Farid.

Essa realidade ficou clara após o incidente.

Diretor de Hollywood Rob Reiner suspeito de assassinato

em dezembroquando os verificadores de fatos da AFP descobriram um clipe gerado por IA usando sua imagem que estava circulando online.

À medida que as ferramentas avançadas de IA se tornam mais difundidas, esta vulnerabilidade não estará mais limitada às celebridades; nomes, imagens e palavras de não-celebridades falecidas também poderiam ser reutilizados para operações de composição.

Os pesquisadores alertaram que a disseminação descontrolada de conteúdo sintético (comumente chamado de lixo de IA) poderia, em última instância, afastar os usuários das mídias sociais.

“O problema da desinformação em geral não é tanto que as pessoas acreditem nela; muitas pessoas não acreditam”, diz o professor Saint Laurent.

“O problema é que, embora assistam a notícias reais, não confiam mais nelas. E com isso (Sola), isso aumentará significativamente.”AFP