Ao longo dos anos, as pessoas muitas vezes acreditaram, pelo menos instintivamente, que ver era acreditar. Agora, o que é falso muitas vezes parece real e o que é real muitas vezes parece falso.

Na primeira semana de 2026, isso já se tornou um enigma que muitos especialistas em mídia dizem que será difícil superar devido aos avanços na inteligência artificial.

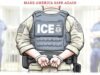

Imagens geradas por IA, vídeos antigos e imagens alteradas da operação do presidente Donald Trump na Venezuela se espalharam pelas redes sociais quase imediatamente. Quarta-feira, Depois que um oficial da Imigração e Alfândega atirou e matou uma mulher em seu carroMuitos online circularam imagens de uma cena falsa, possivelmente editada por IA, que parece ser baseada no vídeo real. Outros usaram IA na tentativa de desmascarar digitalmente o oficial do ICE que atirou nele.

A confusão em torno do conteúdo de IA surge no momento em que muitas plataformas de mídia social, que pagam aos criadores pelo envolvimento, incentivam os usuários a reciclar fotos e vídeos antigos para aumentar a emoção em torno de momentos de notícias virais. A combinação de desinformação, dizem os especialistas, está a criar uma maior erosão da confiança online – especialmente quando é misturada com provas autênticas.

“À medida que começamos a nos preocupar com a IA, ela provavelmente irá, pelo menos no curto prazo, minar o nosso padrão de confiança – isto é, confiamos na comunicação até que tenhamos algum motivo para desconfiar dela”, disse Jeff Hancock, diretor fundador do Stanford Social Media Lab. “Vai ser um grande desafio, por algum tempo as pessoas não vão acreditar realmente no que veem no espaço digital.”

Embora a IA seja a tecnologia mais recente a suscitar preocupações sobre a crescente desinformação, quebras de confiança semelhantes ocorreram ao longo da história, desde a desinformação eleitoral em 2016 até à produção em massa de propaganda após a invenção da imprensa no século XV. Antes da IA, existia o Photoshop, e antes do Photoshop, existiam técnicas de manipulação de imagens analógicas.

Os acontecimentos noticiosos de rápida evolução são onde os meios de comunicação manipulados têm maior impacto, disse Hancock, porque colmatam uma enorme falta de informação.

No sábado, Trump compartilhou uma foto do líder venezuelano deposto Nicolas Maduro, vendado e algemado, em um navio de ataque da Marinha em sua conta social Verified Truth. Logo depois, imagens não verificadas em torno da captura – algumas das quais mais tarde se revelaram Vídeo gerado por IA – Outras plataformas de redes sociais começam a inundar.

como Celebração real Conforme revelado, o proprietário do X, Elon Musk, estava entre os que o compartilharam Vídeo gerado por IA Os venezuelanos agradecem aos EUA por prenderem Maduro.

Evidências geradas por IA já existem entrou na sala do tribunal. Deepfakes de IA há As autoridades também foram enganadas – no final do ano passado, houve uma enxurrada de vídeos online gerados por IA Soldados ucranianos pediram desculpas ao povo russo e em grande parte rendeu-se às forças russas.

Hancock disse que, embora a desinformação ainda chegue online através de meios mais tradicionais, como pessoas que usam indevidamente a mídia real para pintar uma narrativa falsa, a IA está rapidamente jogando mais lenha na fogueira.

“Em termos de apenas olhar para uma foto ou vídeo, será basicamente impossível detectar se é falso ou não. Acho que estamos chegando perto desse ponto, se é que já não chegamos lá”, disse ele. “O antigo conceito de alfabetização em IA de ‘vamos apenas olhar para o número de dedos’ e coisas assim provavelmente desaparecerão.”

Uma grande dificuldade para os pesquisadores que estudam IA é que os humanos experimentam fadiga cognitiva ao tentarem navegar no grande volume de conteúdo real e sintético online, disse Renee Hobbs, professora de estudos de comunicação na Universidade de Rhode Island. Isso torna difícil para eles descobrir o que é real e o que não é.

O antigo conceito de alfabetização em IA de “vamos apenas olhar para o número de dedos” e coisas do gênero provavelmente desaparecerá.

Jeff Hancock, diretor fundador do Stanford Social Media Lab

“Se a dúvida e a ansiedade constantes são o que acreditar é a norma, então, de fato, o isolamento é uma resposta racional. É um mecanismo de enfrentamento”, disse Hobbs. “E então, quando as pessoas param de pensar se algo é verdade ou não, o perigo não é apenas o engano, na verdade é pior do que isso. É o colapso total de estar motivado para encontrar a verdade.”

Ele e outros especialistas estão trabalhando para descobrir como incorporar a IA generativa na educação para a alfabetização midiática. A Organização para a Cooperação e Desenvolvimento Económico, uma organização intergovernamental de países democráticos que colabora em normas políticas, deverá publicar um relatório global Avaliação da alfabetização em mídia e inteligência artificial Para jovens de 15 anos em 2029, por exemplo.

Mesmo alguns gigantes das redes sociais que adotaram a IA generativa estão cautelosos quanto à sua intrusão em algoritmos humanos.

UM Postagens recentes no tópicoO chefe do Instagram, Adam Mosseri, abordou suas preocupações sobre a desinformação sobre IA se tornar mais comum em toda a plataforma.

“Durante a maior parte da minha vida posso assumir com segurança que a maioria das fotografias ou vídeos que vejo são capturas precisas de momentos da vida real”, escreveu ele. “Esse claramente não é mais o caso e levará anos para que nós, como humanos, nos adaptemos.”

Mosseri previu que os usuários da Internet “passarão de assumir que o que vemos como real por padrão, para serem céticos quando assistimos à mídia e prestarem muito mais atenção a quem está compartilhando algo e por que o estão compartilhando. Será incrivelmente desconfortável para todos nós porque confiamos geneticamente em nossos olhos”.

Hany Farid, professor de ciência da computação na Escola de Informação da UC Berkeley, disse que sua recente pesquisa sobre detecção de deepfake mostrou que as pessoas são tão propensas a chamar algo real de falso quanto a dizer que algo falso é real. As taxas de precisão são significativamente piores quando as pessoas vêem conteúdo com conotações políticas – porque então entra em ação o viés de confirmação.

“Quando eu lhe envio algo que é consistente com sua visão de mundo, você quer acreditar. Você é encorajado a acreditar”, disse Farid. “E se for algo que contradiz sua visão de mundo, você fica muito encorajado a dizer: ‘Oh, é falso.’ E então, quando você adiciona esse preconceito a isso, tudo fica fora da água.”

As pessoas estão familiarizadas com pessoas em quem podem confiar imediatamente – como celebridades, políticos, familiares e amigos – por isso, à medida que as simulações de IA de tais números se tornam mais realistas, também será mais provável que enganem as pessoas, disse Siwei Liu, professor de ciências da computação na Universidade de Buffalo.

Liu, que ajuda a manter uma plataforma de detecção de IA de código aberto Deepfake-O-MeterDito isto, os usuários comuns da Internet podem melhorar suas habilidades de detecção de IA apenas prestando atenção. Mesmo que não tenham o poder de analisar cada pedaço de mídia que aparece em seu caminho, diz ele, as pessoas deveriam pelo menos se perguntar por que acreditam ou não no que veem.

“Em muitos casos, pode não ser a própria mídia que há algo errado, mas é no contexto errado ou por alguém em quem não podemos confiar totalmente”, disse Liu. “Portanto, penso que, no geral, a consciência geral e o bom senso são as medidas de segurança mais importantes que temos e não requerem formação especial”.