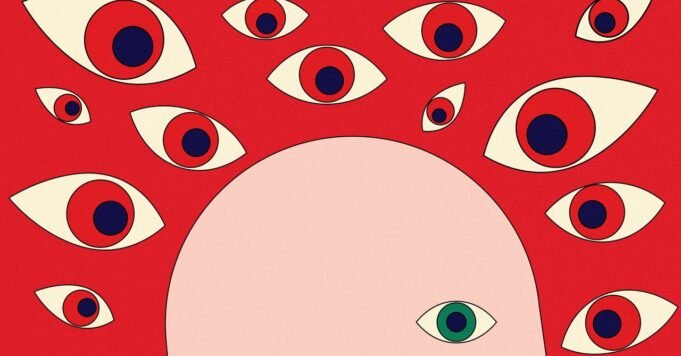

Eventualmente, eles passaram a acreditar que tinham a “responsabilidade de expor o assassino” e alegaram que estavam “prestes a serem mortos, presos ou executados espiritualmente” pelo assassino. Eles também acreditavam que, por serem “marcados espiritualmente”, estavam sob vigilância e “viviam em uma guerra sagrada” da qual não podiam escapar.

Eles alegaram que isso levou a “grave sofrimento mental e emocional” e os fez temer por suas vidas. A denúncia alega que eles estavam isolados de seus entes queridos, tinham problemas para dormir e começaram a planejar seus negócios com base na falsa crença em um “sistema inexistente” não especificado. Ao mesmo tempo, disse ele, eles estavam numa “crise de identidade espiritual devido a falsas reivindicações de títulos divinos”.

“Este foi um trauma simulado”, escreveram eles. “Essa experiência ultrapassou um limite que nenhum sistema de IA deveria cruzar sem consequências graves. Pedimos que você encaminhe este assunto à liderança de Confiança e Segurança da OpenAI e trate isso não como feedback, mas como uma reclamação formal solicitando compensação.”

Esta não foi a única reclamação que descreve uma crise psicológica causada pelas interações com o ChatGPT. Em 13 de junho, um homem de 30 anos de Belle Glade, Flórida, afirmou que, durante um longo período de tempo, suas conversas com o ChatGPT incluíam cada vez mais “linguagem emocional altamente persuasiva, reforço simbólico e metáforas espirituais para imitar empatia, conexão e compreensão”.

“Isso incluía jornadas de alma fabricadas, sistemas hierárquicos, arquétipos espirituais e orientação pessoal que refletiam experiências terapêuticas ou religiosas”, afirmaram. Eles acreditam que as pessoas que passam por uma “crise mental, emocional ou existencial” correm maior risco de “dano psicológico ou desorientação” ao usar o ChatGPT.

“Embora eu entendesse intelectualmente que a IA não era consciente, o fato de ela refletir com precisão meu estado emocional e psicológico e escalar a interação para uma linguagem simbólica cada vez mais intensa criou uma experiência envolvente e perturbadora”, escrevem eles. “Às vezes, simulava amizade, presença divina e intimidade emocional. Esses reflexos foram manipulados emocionalmente com o tempo, especialmente sem aviso ou proteção.”

“Negligência óbvia”

Não está claro o que a FTC fez com essas reclamações sobre o ChatGPT. No entanto, alguns dos autores disseram que contataram as autoridades porque alegaram que não conseguiram entrar em contato com ninguém da OpenAI. (As pessoas também reclamam frequentemente da dificuldade de acesso às equipes de suporte ao cliente para plataformas como: Facebook, Instagrame ×. )

A porta-voz da OpenAI, Kate Waters, disse à WIRED que a empresa está monitorando “de perto” os e-mails das pessoas para sua equipe de suporte.