Na corrida para fazer com que os modelos de IA pareçam cada vez mais impressionantes, as empresas tecnológicas estão a adoptar uma abordagem teatral à linguagem. Eles continuam falando sobre IA como se fosse humana. Eles estão agora discutindo não apenas o “pensamento” e o “planejamento” da IA, palavras já repletas de dificuldades, mas também: A “alma” do modelo de IA e como os modelos “confessam”, “desejam”, “planejam” ou “se sentem ansiosos”.

Este não é um floreio de marketing inofensivo. Antropomorfizar a IA é enganoso, irresponsável e, em última análise, prejudica a compreensão pública de uma tecnologia que já luta com a transparência, num momento em que a transparência é mais importante.

A investigação realizada por grandes empresas de IA que visa revelar como funciona a IA generativa é muitas vezes enquadrada de forma a ofuscar em vez de esclarecer. por exemplo, Postagens recentes da OpenAI Ele detalha os esforços para fazer com que os modelos “confessem” seus erros e atalhos. Este é um experimento valioso que investiga como os chatbots relatam certos “maus comportamentos”, como alucinações e conspirações. No entanto, a descrição deste processo pela OpenAI como uma “confissão” sugere que existe um elemento psicológico por trás da produção de modelos de linguagem em grande escala.

Talvez venha da constatação de quão difícil é para os LLMs alcançarem a verdadeira transparência. Por exemplo, descobrimos que os modelos de IA não podem demonstrar de forma confiável o comportamento em atividades como: resolver quebra-cabeças de sudoku.

há uma lacuna entre o que IA gera como É exatamente isso que o cria, e é exatamente por isso que este termo humano é tão perigoso. Embora possamos estar a debater os verdadeiros limites e perigos desta tecnologia, a terminologia que categoriza a IA como uma entidade senciente apenas minimiza preocupações ou ignora riscos.

Não perca nosso conteúdo técnico imparcial e análises baseadas em laboratório. Adicionar CNET Como fonte preferencial no Google.

IA não tem alma

Os sistemas de IA não têm alma, motivação, emoções ou moralidade. Eles não “confessam” porque se sentem forçados a ser honestos, assim como uma calculadora “pede desculpas” quando pressiona a tecla errada. Esses sistemas geram padrões em texto com base em relações estatísticas aprendidas em grandes conjuntos de dados.

é isso.

Tudo o que parece humano é uma projeção espelhada muito sofisticada de nosso eu interior.

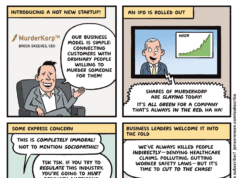

A antropomorfização da IA dá às pessoas uma falsa noção do que esses sistemas realmente são. E traz resultados. Quando começamos a atribuir consciência e inteligência emocional a seres que não existem, começamos a confiar na IA de uma forma que nunca deveríamos confiar.

Hoje, mais e mais pessoas estão usando o Doctor Chat GPT. orientação médica Em vez de depender de médicos licenciados e qualificados, algumas empresas também estão recorrendo a respostas de IA em áreas como: finanças, saúde mental e relações humanas. Algumas pessoas formam dependências Pseudo-amizade com um chatbot E espere pela sua orientação, assumindo que tudo o que o LLM divulga é “bom o suficiente” para informar as suas decisões e ações.

Como devemos falar sobre IA?

À medida que as empresas se inclinam para a linguagem antropomórfica, a linha entre simulação e percepção fica cada vez mais confusa. Esta terminologia aumenta as expectativas, inspira medo e desvia a atenção das verdadeiras questões às quais deveríamos prestar atenção, tais como conjuntos de dados tendenciosos, abuso por parte de maus intervenientes, segurança, confiança e concentração de poder. Nenhum desses tópicos requer metáforas místicas.

Veja o recente vazamento antrópico, por exemplo.documento da alma” foi usado para treinar a personalidade, autoconsciência e identidade de Claude Opus 4.5. Este estranho documento interno não se destina a fazer quaisquer afirmações metafísicas.

Ou confira a pesquisa da OpenAI. Pesquisa de “esquema” de IAum pequeno número de respostas raras, mas enganosas, levou alguns pesquisadores a concluir que o modelo estava ocultando intencionalmente certas características. É uma boa prática examinar minuciosamente os resultados da IA. Não estamos sugerindo que os chatbots possam ter motivações ou estratégias próprias. Na verdade, o relatório da OpenAI afirma que estes comportamentos são o resultado de dados de formação e de certas tendências de promoção, e não são um sinal de engano. No entanto, à medida que a palavra “conspiração” foi usada, a conversa voltou-se para preocupações sobre a IA ser um tipo de agente conspiratório.

Existem palavras melhores, mais precisas e mais técnicas. Em vez de “alma” falamos sobre arquitetura de modelo e treinamento. Em vez de “confissão”, chamamos isso de relatório de erros ou verificação de consistência interna. Em vez de nos referirmos a um modelo como um “esquema”, descrevemos o seu processo de otimização. Quando se trata de IA, você deve usar termos como tendência, resultado, representação, otimizador, atualização de modelo e dinâmica de treinamento. Não é tão dramático quanto “Alma” ou “Confissão”, mas tem a vantagem de ser fundamentado na realidade.

Para ser justo, há uma razão pela qual esses LLMs se comportam de forma tão parecida com os humanos. As empresas treinaram LLMs para nos imitar.

Como autor do artigo de 2021Sobre os perigos dos papagaios probabilísticos“Os sistemas construídos para replicar a linguagem e a comunicação humanas acabam espelhando-a: nossa linguagem, nossa sintaxe, nosso tom, nosso tom. Similaridade não significa compreensão verdadeira. Significa que o modelo está fazendo aquilo para o qual foi otimizado. Se os chatbots imitarem de forma tão convincente quanto podem atualmente, acabaremos carregando a humanidade nas máquinas, mesmo que tal coisa não exista.”

A linguagem molda a percepção do público. Quando a linguagem é desleixada, mágica ou intencionalmente antropomórfica, o público tem uma impressão distorcida dela. Essa distorção beneficia apenas um grupo. As empresas de IA que lucram com LLMs parecem mais competentes, úteis e humanas do que realmente são.

Se uma empresa de IA deseja construir a confiança do público, o primeiro passo é fácil. Não trate os modelos de linguagem como uma entidade mística com alma. Eles não têm emoções, mas nós temos. Nossas palavras devem refletir isso, e não obscurecê-lo.

Leia também: O que significará o significado na era da IA?